PRINCIPIOS BÁSICOS DE ESCALADO

Dr. Roberto A. González

Castellanos

Profesor Titular Adjunto

Investigador Auxiliar

Centro de Estudios de

Combustión y Energía (CECYEN)

PROLOGO

Las presiones competitivas en la industria química y en la biotecnológica hacen cada vez más necesario contar con procedimientos que permitan escalar lo más rápido y directo posible, desde los laboratorios de investigación y desarrollo. para poder acortar el tiempo que transcurre entre la concepción de un nuevo proceso y la puesta en marcha de la planta correspondiente, a escala industrial.

Esta tarea no puede cumplirse sin un dominio y aplicación adecuada de las técnicas de esalado y por esa razón, este texto tiene como objetivos generales:

Presentar de forma ordenada los fundamentos de los métodos de escalado, definiendo adecuadamente ese término.

Introducir el concepto de Ingenierización en los trabajos de Investigación y Desarrollo.

Conocer los procedimientos de aplicación del escalado en la solución de los problemas relacionados con el desarrollo de tecnologías y procesos industriales, a partir de resultados científicos obtenidos en los laboratorios.

Conocer algunas de las aplicaciones prácticas de los métodos estudiados.

Conocer la teoría y los fundamentos de las plantas piloto, definiendo la naturaleza de su actividad y las opciones disponibles para la utilización de las mismas.

Para cumplir esos objetivos se han considerado seis capítulos. Para la confección de los capítulos 2, 3 y 4 se tomó como base el clásico texto de Johnstone y Thring "Pilot Plants, Models and Scale-up in Chemical Engineering" , y en especial sus capítulos 2, 3, 4, 5, 6, 7. 8 y 9 y los Apéndices 1 y 2, traducidos y actualizados. El Capítulo 1 se redactó tomando como base los materiales de los Talleres Internacionales sobre Escalado realizados en la Habana en 1992, 1993 y 1995 y para el resto se tomaron como base principalmente artículos de revistas actualizadas de la especialidad y textos como "La Teorìa de los Modelos en la Ingenierìa de Procesos" de J. Rosabal

CAPITULO 1

INTRODUCCION AL

ESCALADO INDUSTRIAL

1.1 Problemas que surgen relacionados con el cambio de escala.

En el escenario de la investigación y el desarrollo de nuevas tecnologías está presente siempre la problemática de cómo convertir en una estructura económica de producción los conocimientos logrados en el laboratorio, concatenándolos con otros conocimientos ya establecidos, para poder llegar de esa forma a una escala comercial de producción.

En este proceso de cambio de escala surgen problemas que en muchas ocasiones son ignorados completa o parcialmente y esa ha sido la causa de no pocos fracasos. Estos problemas pueden ser agrupados en dos tipos fundamentales: los que se relacionan exclusivamente con la necesidad de manejar grandes volúmenes de material y aquellos en que la naturaleza misma del problema se ve afectada por el tamaño de la escala de operación (Wiseman, 1986).

En el primer caso se tienen los problemas relacionados con los sistemas de enfriamiento, calentamiento y tratamiento de residuales, los cuales se llevan a cabo con relativa facilidad a nivel de laboratorio y requieren generalmente de equipos costosos y complejos cuando se realizan en la escala industrial. También son de este tipo de problemas los relacionados con la necesidad de utilizar diferentes materiales al paso a una escala mayor, como ocurre al emplear reactivos químicos comerciales en lugar de los de grado analítico o la utilización de recipientes metálicos en lugar de los de vidrio, lo que puede introducir problemas de contaminación.

Los problemas del segundo tipo surgen cuando los distinto parámetros del proceso se ven afectados de manera diferente por el tamaño de la unidad. Un ejemplo sencillo puede ser el efecto que sobre la superficie específica de un recipiente tiene el cambio de escala. Una serie de recipientes de proprociones geométricamente similares (Capítulo 2), pero de diferentes volúmenes, tienen un volumen que es proporcional al cubo del diámetro del recipiente, pero la superficie de la pared es proporcional al cuadrado del diámetro del recipiente, de manera que la superficie específica, que afecta a la transferencia de calor en las camisas refrigerantes, es proporcional al inverso del diámetro del recipiente.

Los microorganismos porpoprcionan otro ejemplo muy espectacular de este principio, ya que una de las características de su eficiencia como sistemas reaccionantes microscópicos es su gran superficie con respecto a su volumen. Una bacteria tiene un volumen de aproximadamente 5 x 10-19 m3 y una superficie de alrededor de 6 x 10-12, por lo que la superficie específia es de alrededor de 3 x 10 6, mientras que un m3 de agua se puede encerrar en un tanque con una superficie de 6 m2, lo que hace una superficie específica de 6 , o sea un millón de veces menor que la de las bacterias.

En los procesos químicos se tiene que durante la Investigación y Desarrollo de un nuevo producto, uno de los problemas que requiere una atención más estrecha y que en ocasiones llega a ser problemático, es el escalado del reactor. Es aceptado prácticamente por todos que el diseño de un reactor químico a escala comercial, el cual es el corazón de una planta química, no puede llevarse a cabo con un enfoque solamente teórico, por lo cual resulta imprescindible contar con datos de las reacciones involucradas obtenidos a nivel de laboratorio, banco o planta piloto.

Aunque básicamente la velocidad de una reaccion química resulta independiente del tamaño y estructura de un reactor (Tabla 6-1), la misma es influenciada por los procesos físicos, por ejemplo la transferencia de masa y calor, las cuales son controladas por el tamaño y estructura del reactor (30).

Tabla

6-1.Influencia del tamaño

en un número de mecanismos claves en los procesos

químicos, tomado de Trambouze, 1990 (30).

|

Mecanismo |

Variables importantes |

Influencia del tamaño |

|

Cinética Química |

T, C, P |

Ninguna |

|

Termodinámica |

T, C, P |

Ninguna |

|

Transferencia de calor |

Velocidades locales, P, C |

Indirecto |

|

Transf. de masa en una fase fluida |

T, C, Turbulencia |

Indirecto |

|

Transferencia de masa entre fases |

Velocidades relativas de fases, C, T |

Indirecto |

|

Convección forzada |

Rapidez de flujo, Geometría |

Importante |

|

Convección natural |

P, C, T, Geometría |

Determinante |

Por esa causa la reacción química se afecta por el tipo de reactor y el efecto del incremento de escala resulta normalmente impredecible de forma cuantitativa, lo que resulta más complejo aún cuando en la reacción participan diferentes fases, a causa de que los fenómenos no son todos afectados en la misma forma por las dimensiones de una planta (Tabla 6-2) (29).

Tabla 6.2. Efecto de

las dimensiones geométricas en lo fenómenos pirncipales que ocurren en un

reactor con fases múltiples.Tomado de Trambouze, 1979 (29).

|

DIMENSIONES GEOMÉTRICAS |

||||

|

MECA-NISMO |

Volumen ( DL2) |

razón L/D |

Superficie lateral/vol. ( D-1) |

|

|

Reac-ción química |

Fuerte, prácticamente determinante |

Débil e indirecto |

Sin influencia directa |

|

|

Transf. de masa |

No determinante. Indirecto |

Fuerte |

Sin influencia directa |

|

|

Transf. de calor |

Débil e indirecto |

Fuerte |

Fuerte y directo |

|

Un procedimiento de escalado satisfactorio puede requerir un enfoque empírico paso a paso, en el cual el tamaño del reactor se va incrementando paulatinamente, para poder conocer en detalle el efecto del cambio de escala en la velocidad y rendimiento de la reacción. Este procedimiento es largo y costoso.y por ello se han desarrollado un número de métodos semiempíricos alternativos para aliviar esta situación.

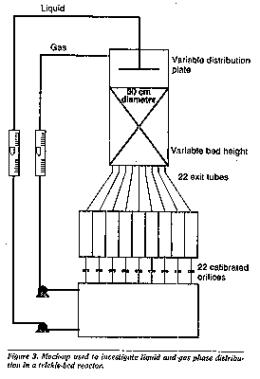

Entre esos métodos está la aplicación del Principio de Semejanza, estudiado en el Capítulo 2, la modelación matemática y el uso de modelos a gran escala (mockups) y en muchas ocasiones los mejores resultados se logran con el uso combinado de los mismos ( 25 ). No obstante, todos esos métodos requieren de los datos cinéticos y termodinámicos básicos, los cuales deben de obtenerse de la literatura si están disponibles o de la experimentación.

1.2. Etapas a considerar en

los trabajos de

Investigación y Desarrollo

(I+D).

El proceso de Investigación y Desarrollo puede considerarse dividido en 5 etapas, niveles o escalas:

. Laboratorio

. Banco

. Piloto

. Semi-industrial

. Industrial

Esta división es convencional y por ello, como veremos más adelante, no son muy precisos los límites entre una escala y otra, ni tienen que considerarse siempre necesariamente todas las escalas, siendo bastante común, por ejemplo, obviar la escala semi-industrial. También hay casos, cuando el proceso es suficientmente conocido y sus características lo permiten, en que puede pasarse directamente de la escala de laboratorio a la escala industrial.

En su concepción más simple, el concepto de escalado se refiere al paso de una escala a otra, durante el proceso de desarrollo de un nuevo producto o tecnología. En ese caso se acostumbra a utilizar el término escalado ascendente (scale-up) al proceso que va desde la escala de laboratorio hasta la escala industrial y escalado descendente (scale-down) al proceso inverso aunque conceptualmente son un mismo y único proceso de escalado y la definición del concepto éscalado es un poco más compleja que el simple tránsito de una escala a otra.

1.3 Definición ampliada del término "escalado".

Para comprender mejor la evolución que han tenido los conceptos relativos al uso de modelos y a las escalas, se debe partir de una de las expresiones más antiguas al respecto, escrita por Leonardo da Vinci en sus "Notas", aproximadamente en el año 1500 y citada por Johnstone y Thring (7) :

"Dice Vitruvio que los pequeños modelos no son útiles para conocer los efectos de los grandes y yo aquí propongo probar que esa conclusión es falsa "

(El Vitruvio a que se refería da Vinci era Marco Vitruvio Polión, arquitecto romano del siglo primero de nuestra era, autor de un tradato De architectura, dedicado a Augusto).

Ya a inicios de siglo, en el primer manual de Ingenieria Química que se conoce, su autor, George E. Davis afirmaba (7):

"A small

experiment made upon a few grammes

of material in

the laboratory will not be much

use in guiding to the erection of a large scale works, but there is no doubt

that an experiment based on a few kilogrammes will give nearly all

the data required ... "

(Un experimento pequeño,

realizado en el laboratorio con

pocos gramos de material no

será muy útil como guía para la construcción

de una planta a

gran escala, pero

no hay duda de que

un experimento basado en unos

pocos kilogramos nos dará casi

todos los datos requeridos ....)

Y en 1916, L. H. Baekeland (2), escribe una de las frases más famosas al respecto y que mejor aclara el propósito final de los experimentos relacionados con los modelos y las plantas piloto:

"Commit your blunders on a small scale and make your profits on

a large scale".

(Cometa sus errores en una escala pequeña y obtenga sus ganancias en una escala grande)

En todas estas expresiones se habla de modelos y escalas, grandes y pequeñas y esos conceptos se unen con el de escalado. Ahora bien ... ¿ Qué entendemos en la actualidad por escalado?

En la práctica existen muchas definiciones del término escalado. Una de las clásicas lo limita al estudio de los problemas asociados a la transferencia de datos del laboratorio y la planta piloto a la producción industrial (1). Una definición más reciente plantea que el escalado hace uso de los datos del laboratorio y/o planta piloto, complementados con modelos a gran escala (mockups) y modelación matemática, para determinar las dimensiones y el tamaño de una unidad industrial (4). Otra definición señala que éste consiste en el complejo de técnicas y metodologías que se utilizan para transferir un proceso desarrollado en una escala menor, a la escala de producción (7). y esta última se ajusta bastante a la concepción actual y por ello tomaremos, como definición de escalado, una variante de la anterior:

Escalado es el proceso mediante el cual se logra la exitosa puesta en marcha y la operación económica de una unidad a escala comercial basándose, al menos en parte, en resultados de investigaciones realizada a una escala más pequeña .

De esta definición de escalado quedan excluídos los casos de diseño de unidades industriales realizados con procedimientos de cálculos tradicionales, para los cuales sólo se necesitan los datos de las propiedades físico-químicas de las sustancias en proceso y las cantidades a procesar para obstener los valores de diseño requeridos.

Para que el concepto de escalado sea aplicado, es imprescindible que el diseño se realice sobre la base de investigaciones que se tengan que realizar con ese fin específico, a una escala inferior a la industrial, pero no se requiere que se transite por todas las etapas convencionales en que se dividen los procesos de I+ D.

El proceso completo, desde la escala de laboratorio hasta la comercial, pasando por trabajos de banco, planta piloto y escala semi-industrial, es largo y costoso y debe ser reducido en todo lo posible, con el fin de acortar el tiempo que media entre la concepción de un producto y su introducción en el mercado.

No existe duda alguna que es técnicamente posible transferir casi cualquier proceso desarrollado a nivel de laboratorio, directamente a la producción industrial a gran escala, si se dispone de suficiente tienpo y dinero, de forma que los diseñadores consideren factores de seguridad suficientemente amplios y que se esté dispuesto a un largo período de puesta en marcha, que permita adiestrar al personal y descubrir las diferentes causas de interrupciones y problemas de operación y afrontar los riesgos inevitables en la operación de nuevos procesos no suficientemente estudiados (7).

Tampoco existe duda que los datos obtenidos en plantas de pequeña escala, correctamente diseñadas y operadas, son mucho más seguros para el diseño que los obtenidos directamente del laboratorio, con lo cual se pueden reducir considerablemente los factores de seguridad en el diseño y reducir apreciablemente el período y los riesgos de la puesta en marcha de las unidades comerciales, pero para obtener dichos datos se requiere a su vez de tiempo y empleo de recursos materiales y humanos (7).

Por todo lo anterior, en todos los casos resulta imprescindible el análisis detallado de las características del proceso que se pretende desarrollar y del nivel de conocimientos que se tiene sobre el mismo, para poder decidir las etapas que hay que acocometer y planificarlas adecuadamente, de forma tal que se emplee el mínimo de recursos y se culmine en el menor tiempo posible.

Las técnicas de escalado se han desarrollado precisamentre con el objetivo de reducir al mínimo indispensable ese tiempo de I+D y en ellas juegan un papel determinante las consideraciones técnico económicas.

Finalmente se debe considerar otro objetivo ligado al concepto de escalado y que es el estudio del comportamiento de una planta en producción existente, a partir de una unidad pequeña que reproduce, en lo fundamental, el funcionamiento de la unidad comercial. Este objetivo cae dentro de la esfera del estudio de los procesos pero en principio no se diferencia del objetivo relacionado con el desarrollo de nuevos procesos, siendo la única diferencia práctica el hecho de que para el estudio de los procesos se requiere, casi siempre, solamente de la etapa equivalente a la planta piloto.

1.4 Alcance de las etapas de I+D.

1.4.1 Criterios a considerar para los límites entre escalas.

Para la definición de los límites entre una escala y otra existe una gran diversidad de criterios y en muchos casos se ha utilizado el volumen de los equipos como el criterio fundamental, particularmente en lo relacionado con la industria Biotecnológica, aunque en ese caso en realidad lo que se trata es de un significado particular del concepto de escalado, bastante más restringido que el concepto de escalado adoptado modernamente.

En la industria Biotecnológica resulta de particular significación el incremento paulatino del volumen en el que se desarrollan los microorganismos, de forma tal de asegurar un crecimiento adecuado, con las condiciones requeridas de asepsia y en un tiempo dado. Normalmente este incremento se regula de manera tal que cada nueva etapa se realice con una carga inicial (inóculo) entre un 5 y un 10 % del volumen efectivo total del equipo en cuestión y esto se efectúa siempre, con independencia de si el proceso es uno ya establecido o un proceso en desarrollo.

Este llamado "escalado" de las producciones Biotecnológicas no tiene realmente nada que ver con el escalado que se estudia en el presente texto, pero ha sido causa de confusión y una de los motivos por los cuales se utiliza mucho el volumen de los equipos como criterio de definición entre las etapas de los procesos de I+D.

También se han utilizado como criterios las relaciones entre las dimensiones lineales de los equipos (factores de escala geométricos), a partir de consideraciones de criterios de semejanza. En ocasiones se toma como valor aproximado que los factores de escala geométricos (lineales) deben estar en el rango de 5 a 15. De esa forma una columna de 2 m de diámetro puede ser escalada por una de 250 mm, lo que representa un factor de escala de 8. No obstante, en la práctica no es raro hallar factores tan bajos como 3 o tan altos como 100.

Una columna de 250 mm normalmente puede ser considerada demasiado grande para una instalación a escala pequeña , incluso para una planta piloto, a menos que se desee procesar una cantidad muy grande de producto y por ello se debe considerar un factor de escalado mayor, por ejemplo 13 y considerar entonces una columna de 150 mm, mucho más adecuada y aún dentro del rango recomendado. Si anteriormente se realizó el trabajo en la escala de banco con una columna de 25 mm de diámetro, los factores de escala empleados han sido 6 y 13, o sea se ha ido avanzando de un diámetro de 25 mm a 150 mm y finalmente a 2000 mm.

Por otra parte, cuando se escalan reactores la tendencia es a considerar el factor de escala por el volumen y esto lleva en ocasiones a considerar factores más elevados que el rango recomendado. Por ejemplo, si una reacción a escala de banco se ha realizado en un recipiente de l2 L y el tamaño final del reactor industrial se estima en unos 11500 L, se puede pensar que serán necesarias dos etapas intermedias, una de 100 L y otra de 1140 L, lo que daría factores de escala de 8, 12 y 10 respectivamente.

Sin embargo, se

puede considerar mejor un valor intermedio de

400 L y en ese caso los factores de escala obtenidos (33 y 29) aunque superiores al rango recomendado,

son también aceptables y esta opción constituye un buen compromiso,

evitando tener que construir dos plantas piloto. Además si se considera la

relación de escala con respecto a la dimensión lineal en lugar del volumen,

lo que es realmente lo recomendado para el escalado, el cuadro cambia totalmente, ya que:

o sea factores de escala modestos, incluso por debajo del rango recomendado.

No obstante, en realidad el mejor criterio de definición de los límites entre las distintas escalas es la de los objetivos que se persiguen con cada una de ellas y los resultados que se esperan. Con ese criterio más amplio se pueden considerar la realización de etapas, por ejemplo de banco y piloto, con equipos de pequeño volumen, normalmente considerados de laboratorio, en los casos en que el nivel de precisión y automatización sea tan elevado y la necesidad de obtener productos de muestra tan pequeña, que se puedan cubrir entonces los objetivos señalados para esas etapas, con un considerable ahorro económico (4, 5, 8).

1.4.2 Escala de laboratorio.

El laboratorio constituye la unidad primaria de investigación en la que quedan determinadas las metódicas de síntesis o procesamiento y se establecen las condiciones bajo las cuales se obtienen los mejores resultados.

El laboratorio confirma o rechaza las hipótesis obtenidas del conocimiento previo y de la literatura y se obtienen datos que contribuyen a enriquecer la información sistematizada, que constituye la base para el trabajo a escala de banco y/o planta piloto. Además se obtiene información para la realización de evaluaciones económicas preliminares y se determinan diversas propiedades físico-químicas, necesarias para los cálculos ingenieriles y la formulación y comprobación de modelos matemáticos.

Los objetivos Principales de esta etapa son la obtención, recuperación y purificación de los productos de interés, asi como el análisis y caracterización de los mismos. Además, en el caso de la Síntesis Química se definen otros objetivos como:

Conocer la influencia de los variable macroscópicas (composición, temperatura, pH, etc.) en el rendimiento u otro parámetro que caracterice la eficiencia del sistema.

Optimización de la síntesis a ese nivel.

Conocimiento de la cinética, incluyendo la construcción de modelos matemáticos.

Propiedades físicas y químicas del nuevo producto.

Influencia de los reactivos empleados en los cambios de escala.

Caracterización de los subproductos y residuales.

Evaluación económica preliminar.

En el caso de los procesos biotecnológicos, se tienen como objetivos :

Selección y evaluación de cepas.

Optimización del medio y de otras variables experimentales y de proceso.

Información en cortos plazos de tiempo a muy bajo costo.

1.4 3 Escala de banco.

En esta etapa la investigación comienza a adquirir un carácter tecnológico y posee sus particularidades que la distinguen (6):

Se orienta a la configuración de las unidades experimentales con características geométricas y operacionales similares a los equipos de planta piloto o industriales disponibles o recomendables, a diferencia de la etapa de laboratorio, donde el equipamiento utilizado difiere considerablemente del industrial.

Conlleva un mayor nivel de instrumentación y automatización .

El trabajo experimental se orienta hacia el completamiento y precisión de la informacion de laboratorio.

Los estudios de banco constituyen un paso de gran importancia y pueden contribuir a reducir considerablemente los costos de la investigación y obviar, en algunos casos, la necesidad de los trabajos a escala piloto.

Los objetivos principales de esta etapa son :

1. Revelar la esencia de los fenómenos que ocurren en los procesos.

2. Revelar los pasos controlantes o críticos en las operaciones.

3. Verificar hipótesis de modelos matemáticos.

4. Aportar información para cálculos y diseños de ingeniería.

Además en el caso de la

Síntesis Orgánica, hay otros

objetivos como:

Realizar estudios fundamentales de ingeniería de procesos como los fenónemos de superficie, fenómenos reológicos, equilibrio de fases, separaciones complejas, estudios de materiales, etc.

Determinar propiedades y características físico-químicas de las sustancias como la densidad, viscosidad, tensión superficial, tamaño de partículas, porosidad, calor específico, etc.

Conocer la Termoquímica (calores de reacción) y Termofísica (capacidad calorífica de las mezclas,etc).

En el caso de los procesos

biotecnológicos se consideran también

los siguientes objetivos:

1. Selección del procedimiento de desarrollo de inóculos, esterilización del medio, aireación, agitación y operaciones de purificación.

2. Ajuste de variables como razón de transferencia de oxígeno, evolución de dióxido de carbono, producción de biomasa, biosíntesis de metabolitos y efectos del pH.

3. Estudio del régimen de alimentación continua o incrementada.

4. Selección de alternativas de control e instrumentación.

5. Evaluación económica preliminar y estimado de viabilidad del proceso.

Esta etapa permite un enfoque científico a relativo bajo costo.

1.4.4. Escala piloto.

Los estudios de escala piloto resultan de especial importancia para el cambio de escala en muchos procesos, pero poseen un alto costo y la decisión de su realización debe estar subordinada a un conjunto de factores entre los cuales se destacan:

Tipo de proceso

Nivel de información disponible

Tamaño propuesto para la unidad industrial

La planta piloto debe montarse y operarse de manera que permita satisfacer al menos uno de los siguientes objetivos principales:

1. Evaluar la factibilidad de un proceso tecnológico.

2. Obtener la información para el diseño de una planta comercial.

3. Obtener cantidades de productos con fines de ensayo o promoción.

Además de estos, en el caso de

la Síntesis Orgánica se tienen los siguientes objetivos específicos:

Obtener "know-how" del proceso.

Corroborar teorías sobre mecanismos de los procesos.

Obtener informnación para el tratamiento de residuales.

Ensayar materiales de construcción.

Probar métodos de análisis de procesos y control de calidad.

Estudiar sistemas para el control de procesos.

Evaluar nuevos equipos y sistemas tecnológicos.

Entrenar al personal.

En el caso de

los procesos biotecnológicos, se tienen los siguientes objetivos específicos:

1. Confirmar los datos obtenidos a nivel de banco y verificar los criterios de escalado.

2. Selecciónar las estrategias de esterilización del medio y de concentración y purificación de productos.

3. Obtener cantidades de productos para pruebas de caracterización, toxicológicas, promoción de mercado y verificación de la viabilidad del proceso.

4. Ofrecer una información de validación a un costo relativamente alto .

1.4.5 Escala semi-industrial..

Esta es una etapa cara del proceso de escalado que puede prolongar excesivamente la introducción de una nueva tecnología en el mercado y sólo se realiza para aquellas tecnologías de una gran complejidad y que representan un salto apreciable en el nivel de desarrollo existente (14).

En ocasiones, a las plantas de este tipo se le han denominado plantas demostrativas, aunque otros autores prefieren el término de plantas prototipo (3,4). Estas plantas se construyen de igual forma que una planta de escala completa, pero a una capacidad de producción menor, usualmente un décimo de la proyectada para la escala definitiva, que permite el acopio de experiencias durante su funcionamiento y sirve de modelo a las futuras plantas in dustriales que se construyan (14).

En la mayoría de las ocasiones esta etapa del escalado puede omitirse, lo que representa una considerable reducción en el periodo de desarrollo de una tecnología.

1.4.6 Escala industrial.

Normalmente esta escala no se considera una parte del proceso de investigación y desarrollo y esto constituye un error conceptual con fuertes implicaciones de índole práctica.

Realmente la industria constituye, no sólo una prueba de validación de las experiencias precedentes, sino que enriquece la información ingenieril disponible y los modelos matemáticos formulados y brinda información de gran valor para el perfeccionamiento de equipos y para la optimización del propio proceso productivo (6).

Además en la mayoría de los casos las instalaciones a escala de banco y/o piloto se diseñan a partir de un "scale-down" de la instalación industrial existente o supuesta, en base a la experiencia acumulada con la operación de otras industrias. Por todo lo anterior, la escala industrial debe ser considerada una etapa importante en el conjunto de las tareas de I+D.

1.5 Concepto de Ingenierización.

El concepto de ingenierización ha comenzado a tomar fuerza en los últimos años y a menudo se confunde total o parcialmente con el escalado de los procesos productivos (6).

Anteriormente se concebía el trabajo de los ingenieros como una etapa posterior al logro científico, y el trabajo se organizaba de una manera secuenciada, donde las distintas especialidades entran según les llega su turno. Sin embargo esta manera de trabajar ha llevado a muchos fracasos y, en el mejor de los casos, provoca un alargamiento del período necesario para la introducción de un logro científico en la práctica social.

Esta forma anticuada de desarrollar un producto puede ser ejemplificado de la forma siguiente (12):

"Un químico inventa un nuevo producto químico o proceso en su laboratorio y lo estudia intensamente en una microescala. Obtiene una gran cantidad de información con estudios de parámetros no cuantitativos y como resultado puede obtener varias patentes que incrementan su prestigio cientifico, así como el de la institución a la cual pertenece.

La nueva invención se lleva al departamento de desarrollo comercial, el cual trabaja para hallar un mercado adecuado para tan maravilloso producto y para ello se comienza por la realización de un análisis económico. El entusiasmo de los dirigentes y la utilización de los datos no cuantitativos obtenidos por el químico, hacen que los cálculos muestren al producto como un seguro triunfador y eso hace que el entusiasmo aumente más aún.

La presión ejercida sobre el departamento de desarrollo comercial hace que encuentren el nuevo mercado lo antes posible y con ello se confirman las optimistas predicciones del estudio económico y el proyecto se pasa al departamento de desarrollo. Hasta ese momento el trabajo se ha ido realizando en plazos de tiempo inferiores a los del cronograma de trabajo y el ambiente de optimismo hace pensar que el trabajo del ingeniero de desarrollo no puede hacer otra cosa que confirmar los datos del químico y del departamento comercial.

Pero desgraciadamente en la inmensa mayoría de los casos esto no ocurre así. El ingeniero realiza estudios de planta piloto y siempre encuentra problemas como pueden ser: peores rendimientos y selectividades que las predichas, menores tiempos de vida de los catalizadores, problemas con componentes trazas en la materia prima, etc.

Después que encuentra un mínimo de dos o tres problemas, el ingeniero los discute con el químico y generalmente esto lo disgusta. El químico piensa que su maravillosa invención está siendo torpedeada por el ingeniero y las relaciones entre ambos comienzan a deteriorarse, lo que dificulta y alarga considerablemente el proceso de introducción del producto al mercado, si es que realmente se puede llevar el producto a vías de hecho.

Con ese método de trabajo el químico pudo alcanzar varias patentes y realizar un número adecuado de publicaciones que acrecienta su prestigio, los especialista de desarrollo comercial probaron sus habilidades en la búsqueda de nuevos mercados, el ingeniero demostró su habilidad en el trabajo a nivel de planta piloto, pero la institución no logró resarcirse de los gastos realizados o en el mejor de los casos, tuvo una demora considera ble en obtener ganancia así como una reducción apreciable en la magnitud de las mismas".

El concepto moderno de ingenierización es totalmente distinto a esa forma de trabaja:

La ingenierización contempla la interacción de los ingenieros de las distintas especialidades (químicos, bioquímicos, mecánicos, eléctricos, industriales, etc.) junto con los investigadores de laboratorio (químicos, bioquímicos, biólogos, médicos, físicos, etc.), desde el inicio mismo del proceso de I+D (6, 12, 13 y 17).

Aquí en lugar de la Ingenieria por etapas o Secuencial del enfoque tradicional se emplea el concepto de Ingeniería concurrente (17), lo que lleva a la utilización de equipos multidisciplinarios, prácticamente desde el inicio del proceso de escalado. Para la aplicación de la Ingenieria concurrente se necesitan algunos requisitos elementales, como son (15):

1. Tener facilidades de comunicación entre el colectivo, que en ocasiones resulta bastante numeroso.

2. Usar técnicas de trabajo en grupo y técnicas de solución de problemas.

3. Disponer de locales de trabajo adecuados y servicios de oficina y de apoyo en general.

4. Disponer de bases de datos comunes.

Además, a este enfoque de trabajo se oponen muchos procedimientos establecidos y actitudes, entre las que se destacan (15):

Departamentalización estructural

Sistema de estimulación diseñado para el individuo y no para el colectivo.

Dirigentes apegados a dar soluciones simples a problemas complejos.

No obstante estas dificultades la Ingeniería concurrente y en general la Ingenierización, ha demostrado su utilidad práctica y esta forma de trabajar integrado en grupos multidisciplinarios ha sido adoptada a nivel mundial, especialmente a partir de la década del 90. (6, 12, 13, 15, 17).

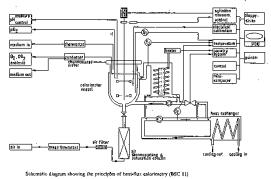

En esta concepción (Figura 1.1), se parte de que en la generalidad de los casos, el surgimiento de un nuevo producto o tecnología es consecuencia de una demanda social que impone la necesidad de una respuesta tecnológica y de una demanda de mercado que estimula una respuesta de la que se esperan varias ventajas económicas o de otra índole, por lo cual la iniciativa para el desarrollo surge generamente de instituciones o empresas motivadas por la interacción del factor social y del mercado (11).

Este proceso constituye realmente una etapa exploratoria y culmina con el planteamiento del problema a resolver por la I+D: la necesidad de un nuevo producto o tecnología (11). Después de planteado el problema viene una etapa preparatoria, en la cual se precisa mejor la tarea y se toman como antecedentes todo el conocimiento anterior aportado por la bibliografía. La investigación bibliográfica reporta una información que debe ser cuidadosamente analizada y ordenada, de forma que pueda ser adecuadamente utilizada en cada etapa de la investigación.

A partir de esa etapa preliminar, que puede incluir un trabajo inicial de laboratorio, comienzan las etapas fundamentales del proceso de desarrollo del nuevo producto o tecnología: las etapas de Ingenierización, en las cuales trabaja un colectivo multidisciplinario y donde las tareas de ingeniería de proceso se realizan en paralelo al trabajo de las distintas escalas (Figura 1.1) (7. 11. 13).

Del trabajo conjunto de investigación e ingeniería, surgen las variantes iniciales del diseño de planta, que sirven en cada caso para diseñar y seleccionar adecuadamente el equipo que se usará en la escala siguiente, pudiéndose decidir incluso la eliminación de algunas de las etapas, si el nivel de información así lo aconseja.

Se llega de esa forma a la etapa final de diseño y proyectos de Ingeniería, donde se realiza toda la documentación final del proyecto (6), la que debe estar compuesta de:

1. Diagrama de flujo y Balances de materiales y energía del proceso en su conjunto ("Flowsheeting del proceso").

2. Definición primaria de las especificaciones de equipos y otros elementos del sistema tecnológico.

3. Diseño de ingenieria de procesos y automática de equipamiento.

4. Diseño de la planta, como un sistema integral, incluyendo los servicios con la calidad requerida, protección del medio y del personal y las buenas prácticas de producción.

5. Proyecto Ejecutivo de los equipos y otros elementos de fabricación nacional.

6. Documentación técnica de puesta en marcha y operación.

En

esta etapa final participa un gran volumen

de ingenieros y técnicos los cuales, en su mayor

parte, han tenido

que estar vinculados al

desarrollo de las etapas anteriores del

proceso de I+D, si se han

cumplido adecuadamente los procedimientos de la ingenierización y

ello conlleva a acortar los

plazos de terminación

mejorar la calidad considerablemente.

En

esta etapa final participa un gran volumen

de ingenieros y técnicos los cuales, en su mayor

parte, han tenido

que estar vinculados al

desarrollo de las etapas anteriores del

proceso de I+D, si se han

cumplido adecuadamente los procedimientos de la ingenierización y

ello conlleva a acortar los

plazos de terminación

mejorar la calidad considerablemente.

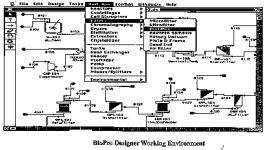

Otro elemento que se debe tener en cuenta en esta etapa final, es la necesidad de aplicar las modernas técnicas de computación que se han desarrollado, como es el caso de la Ingeniería de Procesos auxiliada por Computadoras (Computer Aided Process Engineering, CAPE) (16), mediante la cual se integra el "flowsheeting" del proceso al manejo de los datos y la confección de la documentación de proyectos correspondiente, de forma automatizada e integrada, lo que reduce sensiblemente el tiempo de proyección y mejora su calidad.

El empleo de la computación se debe hacer también en el resto de las etapas del escalado, siendo un elemento fundamental para el registro y evaluación de los datos obtenidos en los experimentos y en el desarrollo y evaluación de los modelos matemáticos, lo que ayuda también a reducir el número de experimentos y de etapas a realizar, con la consecuente reducción del periodo de tiempo que lleva este proceso.

En la actualidad se dispone de experiencias positivas con la utilización de sistemas computarizados para la recolección y procesamiento de datos (SRD), durante los procesos de escalado (10), las que deben ser tenidas en cuenta en los trabajos que se realicen, en dependencia del equipamiento de control e instrumentación medios de computación de que se dispongan.

1.6 Ejemplos de aplicaciones del escalado en la vida cotidiana.

Por todo lo antes expuesto se puede pensar que el escalado se relaciona solamente con los procesos industriales, lo cual no es cierto, ya que en la vida cotidiana se debe hacer uso de estos conceptos, aunque en la mayoría de los casos es probable que se haga de forma intuitiva o incluso incorrecta. Un ejemplo de su aplicación en una actividad cotidiana está en la cocina. Si se revisa un libro típico de esta especialidad como es "Cocina al Minuto", de Nitza Villapol (Editorial Oriente, Santiago de Cuba, 1988), se puede encontrar (página 28):

" Se aconseja no duplicar o triplicar una receta la primera vez que usted la pruebe. La cocina, en cantidades mayores requiere ligeras modificaciones de condimentos y tiempo de cocción, además de condiciones apropiadas en cuanto a utensilios y refrigeración. La mayoría de las recetas que aparecen en este libro han sido calculads para condiciones domésticas".

En ese párrafo está claro la referencia a los problemas de escalado relacionados principalmente con el aumento de volumen (cocina doméstica vs. cocina a gran escala, por ejemplo en un comedor de gran capacidad), aunque también hay referencia a los problemas del segundo tipo en lo relacinado con las modificaciones de condimentos y tiempo de cocción.

También puede leerse, en esa misma página: "Para reducir una receta a la mitad use exactamente el 50% de todos los ingredientes....... Para duplicar la receta use exactamente el doble de todos los ingredientes.... Para hacer la mitad de las recetas de pasteles, cakes, etcétera, deben seleccionarse moldes más pequeños en proporción a esa cantidad, para que el tiempo y la temperataura de horneo sean similares. Si se usa el mismo tamaño del molde para la mitad de la receta, el tiempo de horneo será aproximadamente la mitad, pero eso no siempre es recomendable, ni asegura los mejores resultados. Lo mejor es utilizar moldes más chicos".

"Para duplicar la receta.... si se trata de cakes o panetelas deberá usarse, para más seguridad, doe moldes del tamaño que indica la receta, pero si se desea podrá usarse uno que tenga el doble de capacidad, cuidando el tiempo de horneo, que será entonces mayor y muy variable de acuerdo con las condiciones del medio".

¿Puede Vd. explicar cuáles son las variaciones que se producen en el horneo durante el escalado (ascendente o descendente) que hacen necesario variar el tiempo de horneo?.

1.7 Situación del escalado en Cuba.

El insuficiente desarrollo de los procesos de escalado constituye una de las dificultades que se presentan en las condiciones actuales de Cuba, al tratar de avaluar técnica y económicamente los resultados científicos (1). El no dominio de estos procedimientos ha sido la causa de no pocos intentos fallidos y de procesos industriales deficientes (6, 15).

Los ejemplos de este sentido son abundantes y es posible ejemplificarlos con las dificultades que han existido con el desarrollo del proceso industrial de fermentación del bagazo en estado sólido para la producción de alimento animal (sacharina), el cual no ha podido cumplir con las expectativas que los elevados contenidos de proteína obtenidos en las pruebas a pequeña escala, hicieron surgir.

Esta situación hizo necesario que en 1991 el Consejo Científico Superior de la Academia de Ciencias de Cuba (A.C.C.) analizara un estudio realizado al efecto por una Comisión temporal de ese Consejo (1) y que se realizara un estudio similar para su discusión en el Polo Científico del Oeste en 1992 (6). Como resultado de esos análisis se adoptaron un grupo de medidas encaminadas a revertir esta situación, entre las que se destaca la organización de eventos científicos internacionales sobre esa temática, llevados a cabo con éxito en l992, 1993 y 1995.

Otras recomendaciones se refieren al papel que deben jugar los Centros de Educación Superior del país en la profundización del trabajo sobre escalado e ingenierización y en ese sentido destacan las palabras del Ministro de Educación Superior, Dr. Fernando Vecino Alegret, el cual planteó, en su intervención del 2 de mayo de l993, en el Seminario de Perfeccionamiento para dirigentes de la Educación Superior:

"Una insuficiente infraestructura

tecnológica, un pobre

desarrollo de los

procesos de escalado

y la insuficiente evaluación económica, son barreras aún

presentes para alcanzar resultados que reporten verdaderos

beneficios económicos y

sociales, a partir de la investigación científica.

En la solución

de este problema,

las universidades pueden hacer una importante contribución al país, razón

por lo que hemos incluído

entre nuestros objetivos principales trabajar en el escalado e ingenierización de procesos para el desarrollo

de aquellas tecnologías vinculadas

con resultados científicos obtenidos por los

Centros de Educación Superior o por

otras instituciones del

país".

CAPITULO 2

"Técnicas a emplear en el proceso

de Escalado".

2.1 EL PRINCIPIO DE SEMEJANZA

2.1.1 Modelos y prototipos

Para cumplir con el objetivo del escalado, o sea obtener un procedimiento industrial exitoso, se necesita aplicar un conjunto de técnicas, metodologías y procedimientos que permitan transferir a la escala industrial, los datos obtenidos en los experimentos a escala reducida.

Lo ideal sería que este estudio se pudiera realizar de manera teórica, sin necesidad de experimentos, aplicando las leyes generales de la física y la química y resolviendo las ecuaciones, por lo común diferenciales, que describen por completo los procesos.

En la práctica ésto sólo es posible en muy contados casos, ya que si bien en muchas ocasiones se conocen las ecuaciones diferenciales que describen los procesos de interés, en la mayoría de ellas no es posible realizar su integración y por ello no queda otra vía que recurrir a la investigación experimental, es decir a los ensayos y pruebas.

A su vez, en la mayoría de los casos resulta difícil y costoso, cuando no imposible, experimentar directamente con los procesos de interés y no queda otra alternativa que recurrir al empleo de modelos que permitan reproducir, en los laboratorios, los procesos que se quieren estudiar.

El empleo de los modelos hace necesario la aplicación de la Teoría de los Modelos y para ello es fundamental tener en cuenta que en la misma se utilizan un grupo de términos que o bien no son utilizados normalmente o lo que es peor aún, se utilizan con un sentido diferente al que se les da en esta Teoría (Apéndice 1).

De todos esos conceptos, los primarios resultan los de modelo y prototipo, los cuales se definen de la forma siguiente:

"Un modelo es un dispositivo o medio que está concebido de

tal manera que puede ser usado para

predecir el rendimiento

de un prototipo. El prototipo, a

su vez, es el sistema físico a escala completa, que va a ser modelado (8).

El prototipo no tiene necesariamente que existir materialmente antes que su modelo. Lo determinante en el trabajo con modelos y prototipos es la relación que existe entre el comportamiento de las unidades de pequeña y gran escala, con independencia de cual de ellas exista primero en el tiempo.

Lo que sí resulta indispensable, cuando se concibe el modelo de un prototipo aún inexistente, es que esa concepción se haga teniendo en mente el tipo y forma de la unidad a gran escala que se pretende obtener (3), para lo cual se utilizará la información obtenida antes de comenzar las etapas de escalado (2).

Esta consideración hace que en la mayoría de los casos el escalado de un producto o proceso desde el nivel de laboratorio hasta el nivel industrial (scale-up), sea realmente precedido por el proceso de escalado desde el equipo industrial supuesto hasta el laboratorio (scale-down), lo que demuestra que estos dos procesos no son más que etapas de un único e integral proceso de escalado.

Para la realización de ese proceso se utilizan fundamentalmente los métodos basados en el Principio de Semejanza y la Modelación Matemática, o una combinación de ambos (1,11), aunque en este texto se tratará especialmente el método del Principio de Semejanza, de manera tal que con la metodología empleada se puedan conocer los casos en que se necesite el apoyo de la Modelación Matemática.

El Principio de Semejanza se aplica a los sistemas en los cuales se emplean modelos homólogos, o sea aquellos modelos que sólo se diferencian del prototipo en el tamaño o escala. La modelación matemática se aplica tanto a modelos homólogos como a los analógicos, ya sea como método único de escalado en los casos en que existe suficiente información para ello, o en unión con el Principio de Semejanza, en la mayoría de los casos.

2.1.2 El Principio de Semejanza.

El Principio de Semejanza tiene que ver con las relaciones entre sistemas físicos de tamaños diferentes y es por consiguiente fundamental para la ampliación y disminución de escala en los procesos físicos y químicos. Este principio fué enunciado por primera vez por Newton, para sistemas compuestos por partículas sólidas en movimiento y sus primeras aplicaciones prácticas fueron en los sistemas fluídos, campo en el cual ha probado ser particularmente útil (3,4,9).

Muchos científicos relevantes tomaron parte en el desarrollo de la Teoría de los Modelos, formulando el principio de semejanza y sus consecuencias con un alto grado de rigurosidad (3). Las aplicaciones iniciales de este principio fueron en la construcción naval y posteriormente se extendieron a otros campos

de la ingeniería mecánica y civil y a la aeronáutica.

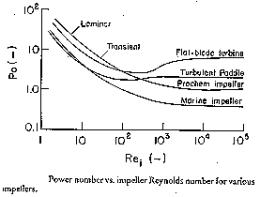

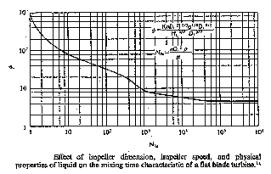

En el campo de la Ingeniería Química, las aplicaciones prácticas iniciales se dirigieron a la correlación del rendimiento de mezcladores de propelas, paletas y turbinas, semejantes geométrìcamente y se extendieron posteriormente a otros campos más complejos hasta llegar al desarrollo y aplicación de la semejanza química para el escalado de los reactores químicos (12, 16, 17).

Para la aplicación del principio (3), se parte de considerar que los objetos materiales y los sistemas físicos en general, se caracterizan por tres cualidades: tamaño, forma y composición, las cuales son variables independientes. Esto quiere decir que dos objetos pueden diferir en tamaño teniendo la misma composìción

química y forma o pueden ser iguales en forma pero tener diferentes tamaños y estar compuestos de materiales diferentes.

El Principio de Semejanza está especialmente ligado con el concepto general de forma, aplicado a sistemas complejos, que incluye no solamente las proporciones geométricas de sus miembros sólidos y superficies, sino también factores como los patrones de flujo de fluídos, gradientes de temperaturas, perfiles de concentración, etc.

En términos más precisos se define que:

El Principio

de Semejanza establece

que la configuración espacial y temporal

de un sistema físico, se

determina por relaciones de

magnitud dentro del sistema

mismo y no

depende del tamaño del sistema

ni de las unidades de

medida en las cuales se miden esas magnitudes.

Estas relaciones de magnitud pueden ser medidas de dos formas diferentes: especificando las proporciones entre diferentes mediciones en el mismo cuerpo (proporciones intrínsecas o factores de forma) o comparando mediciones correspondientes en cuerpos diferentes (relaciones o factores de escala).

En el primer caso se requieren valores de un cierto número de factores de forma para poder definir la configuración de un objeto y por lo tanto su semejanza con otro, mientras que en el segundo basta un único y constante factor de escala para definir esa semejanza.

Como ejemplo de lo anterior tenemos que la forma geométrica de un cuerpo se determina por sus proporciones intrínsecas: (relación altura/ancho, relación ancho/espesor de la pared, etc.) por ello dos cuerpos serán semejantes geometricamente, cuando esos factores de forma son iguales entre ambos. A su vez cuando se comparan dos cuerpos geométricamente semejantes, las relaciones entre sus respectivas alturas, anchos y espesores son constantes y constituyen el llamado factor de escala.

Por esa razón la semejanza geométrica se define mejor en términos de correspondencia y su factor de escala. Sin embargo cuando las comparaciones son hechas con otras variables como la velocidad, la fuerza o la temperatura, la semejanza se define mejor con relaciones intrínsecas para cada sistema, los que constituyen los grupos adimensionales, tan conocidos por los ingenieros. Por tanto, cuando se dice que dos sistemas son semejantes es necesario, además, especificar cuáles son las configuraciones internas de los mismos que se comparan (geométricas, cinemáticas, térnicas, etc).

Con estas definiciones básicas, se está en condiciones de estudiar más detalladamente el Principio de Semejanza y para ello se considerararán los cuatro tipos de semejanza más importantes en las aplicaciones de Ingeniería Química y Bioquímica (8):

1- Semejanza geométrica (dimensiones

proporcionales)

2- Semejanza mecánica:

a- Semejanza estática (deformaciones

proporcionales)

b- Semejanza cinemática (tiempos

proporcionales )

c- Semejanza dinámica (fuerzas

proporcionales)

3- Semejanza térmica (temperaturas

proporcionales)

4- Semejanza química (concentraciones

proporcionales)

Hay que tener en cuenta que si bien estrictamente hablando, cada una de esas semejanzas requiere del cumplimiento de todas las anteriores a ella, es muy difícil lograr eso en la práctica y por ello en muchas ocasiones es necesario aceptar una aproximación, por ejemplo, a la semejanza química, con sustanciales divergencias en la semejanza mecánica.

También hay que considerar que todos los casos de Semejanza de hecho contienen un elemento de aproximación, debido a factores de distorsión que estrán siempre presentes y que impiden que en la

realidad se pueda obtener una semejanza ideal. Por ejemplo, dos conductos para fluidos pueden ser diseñados y construídos con dimensiones geométricamente semejantes, pero es virtualmente imposible hacer también semejante geométricamente la rugosidad superficial, y esas diferencias pueden tener alguna influencia

sobre los patrones de flujo en ambos conductos.

Sin embargo, a menudo esas desviaciones de la semejanza ideal son despreciables y la aproximación obtenida es totalmente válida a los efectos prácticos. En los casos en que no se logre ésto, se tienen que considerar los llamados efectos de escala e introducir correcciones de alguna clase. a la hora de realizar los escalados ascendentes o descendentes.

En estas discusiones sobre semejanza, es necesario referirse frecuentemente a cantidades correspondientes y sus relaciones en sistemas semajantes. En esos casos en el numerador se colocarán siempre las magnitudes referidas al prototipo y se diferenciarán de las del modelo por un apóstrofe. Las relaciones entre ambas cantidades correspondientes se expresarán empleando caracteres en negrita, lo que resulta una forma conveniente y compacta de representar las relaciones de escala.

Semejanza geométrica.

La semejanza geométrica se define mejor en términos de correspondencia y por tanto por el factor de escala L, qurelaciona las distintas dimensiones lineales de un sistema con las del otro y que se pueden ejemplificar de la forma siguiente:

Consideremos dos cuerpos (Figura 2.1) cada uno de los cuales está provisto de tres ejes imaginarios que se intersectan en el espacio, de forma tal que cada punto de los cuerpos es descrito por tres coordenadas y tomemos un punto P' dentro del primer cuerpo (el mayor) cuyas coordenadas son X', Y', Z', y un punto P dentro del segundo cuerpo (el menor), cuyas coordenadas son X. Y, Z.

Si se cumple que ambos están relacionados por la ecuación:

![]()

donde la relación o factor de escala lineal L es constante, se puede decir entonces que esos dos puntos y todos los otros pares de puntos cuyas coordenadas espaciales estén similarmente relacionadas en términos de L, son puntos correspondientes.

Se define entonces que dos cuerpos son geométricamente semejantes cuando para cada punto en uno de ellos existe al menos un punto corrrespondiente en el otro.

El concepto de semejanza geométrica se ilustra en la figura 2.1, donde x - x', y - y' y z -z'. son coordenadas correspondientes, P y P' puntos correspondientes y L y L' longitudes correspondientes.

Figura

2.1 Semejanza geométrica (Tomado de Johnstone y Thring, 1957).

Figura

2.1 Semejanza geométrica (Tomado de Johnstone y Thring, 1957).

Es posible que cada punto del cuerpo a menor escala tenga más de un punto correspondiente en el segundo. Esto ocurre cuando el segundo cuerpo está compuesto de múltiples elementos cada uno de los cuales es geométricamente similar al primer cuerpo. Este es el caso, por ejemplo, de un panal de miel, el cual es geométricamente similar a una célula dodecaédrica única.

Además, no es necesario que las relaciones de escala sean las mismas a lo largo de cada eje y por ello se puede plantear una relación más general, a través de las ecuaciones:

![]()

donde X, Y, y Z, son relaciones de escala constantes, no necesariamente iguales entre sí. En los casos en que las relaciones de escala son diferentes en las distintas direcciones, se considera que se tiene una semejanza distorsionada.

Las aplicaciones de esos conceptos geométricos a las plantas de procesos sugieren diferentes tipos de aparatos a pequeña escala que podían ser considerados semejantes a los aparatos de gran escala. Por conveniencia se ha convenido que los aparatos a gran escala se denominen prototipos,con independencia de si existen primero o después que el aparato de pequeña escala, mientras que una réplica semejante geométricamente de un prototipo completo se denomina modelo, si las relaciones de escala son iguales en todas

las direcciones o modelo distorsionado si las relaciones de escala son diferentes en algunas de las direcciones.

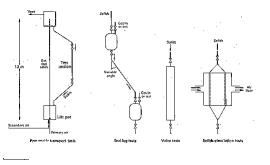

Cuando el prototipo tiene una estructura múltiple, compuesta por elementos sustancialmente idénticos, como por ejemplo, un intercambiador de calor tubular, una torre empacada, un filtro prensa o un reactor catalítico, el aparato a pequeña escala puede ser un elemento, o sea una réplica a escala completa de una o más

células completas o unidades componentes del prototipo. También el aparato a pequeña escala puede ser un elemento modelo, o sea un modelo a escala de un elemento del prototipo completo y ese elemento modelo puede ser además un elemento modelo distorsionado.

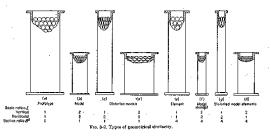

Todas esas relaciones geométricas se ilustran en la figura 2.2, en la que se muestra también la relación de sección B , la cual es la relación entre el área de la sección transversal del prototipo con relación a la del elemento o del respectivo número de células unitarias o componentes. Los modelos son definidos a través de la relación de escala L y los elementos modelos tienen a la vez una relación de sección B y una o más relaciones de escala.

El concepto de elemento es útil solamente cuando los efectos provocados por las paredes del recipiente pueden ser ignorados o controlados independientemente, como es el caso de un reactor catalítico, donde la superficie frontera es normalmente despreciable comparada con la superficie interior.

También puede ser permisible, en ciertas circunstancias, considerar un recipiente vacío como un elemento de uno grande, cuando, por ejemplo, el recipiente pequeño es controlado térmicamente con un enchaquetado adiabático. Lo fundamental en un elemento es que bajo idénticas condiciones debe producir el mismo grado de cambio que produce el prototipo, pero en una menor cantidad de materia.

Por ejemplo una torre empacada es posible dividirla verticalmente en elementos, cada uno de los cuales tiene la misma altura de cama que el prototipo, pero si se divide horizontalmente o se reduce en altura, las partes se convierten en elementos diferenciales los cuales no son susceptibles de ser tratados con los conceptos de semejanza. De igual forma, una sola fila de tubos puede considerarse como un elemento de un condensador vertical (Figura 2.3) (Johnstone y Thring, 1957).

Semejanza mecánica.

Esta semejanza puede ser considerada una extensión del

concepto de semejanza geométrica a los sistemas estacionarios o en movimiento,

bajo la influencia de fuerzas.

Según el tipo

de sistemas y de fuerzas, esta semejanza puede ser estática,

cinemática o dinámica.

Figura 2.2 Tipos de semejanza geométrica (Tomado de Johnstone y Thring,

1957).

Semejanza estática.

La semejanza estática se relaciona con los cuerpos sólidos o estructuras sometidos a tensiones constantes. Todos los cuerpos sólidos se deforman bajo tensión y como resultado de ello, ciertas partes llegan a ser desplazadas de la posición que ocupaban cuando no estaban sometidas a tensión.

Figura 2.3 Una fila de tubos en un condensador vertical, como ejemplo

de elemento (De Johnstone y Thjring, 1957)

Con esa base la semejanza estática se define como:

Dos cuerpos

geométricamente

semejantes son semejantes estáticamente cuando ante tensiones constantes, sus deformaciones

relativas son tales que permanecen geométricamente semejantes.

En ese caso la relación de los desplazamientos correspondientes serán iguales a la relación de escala lineal y los esfuerzos en puntos correspondientes serán también iguales.

Cuando el modelo tiene una semejanza geométrica distorsionada, las relaciones requeridas de las formas correspondientes para la semejanza estática serán diferentes en las diferentes direcciones. Esto ocurre también cuando uno o ambos cuerpos son anisotrópicos y tienen diferentes módulos elásticos en las diferentes direcciones.

La semejanza estática es principalmente de interés para los ingenieros mecánicos y de estructuras, los cuales emplean modelos para predecir las deformaciones elásticas o plásticas de miembros tensionados o de estructuras de formas complejas.

Semejanza cinemática.

La semejanza cinemática se relaciona con sólidos o sistemas fluidos en movimiento, lo que añade a las tres coordenadas espaciales, la dimensión adicional del tiempo.

Los tiempos se miden partiendo de un cero arbitrario para cada sistema y se definen los tiempos correspondientes como los tiempos tales en los cuales t'/t = t constante, siendo t la relación de escala de tiempo. A su vez la diferencia entre pares de tiempos correspondientes se denominan intervalos correspondientes y las partículas semejantes geométricamente que se centran sobre puntos correspondientes en tiempos correspondientes se denominan partículas correspondientes.

La semejanza cinemática se define entonces como:

Los sistemas en movimiento semejantes geométricamente son cinemáticamente semejantes, cuando partículas correspondientes trazan trayectorias semejantes geométricamente, en intervalos de tiempo correspondientes.

El concepto de semejanza cinemática se ilustra en la figura

2.4. Si la relación de escala de tiempo t es mayor que la

unidad, el prototipo

realizará movimientos más

lentos que el

modelo y viceversa. El concepto

de relación de escala de tiempo es

menos familiar que el de relación de escala lineal y por

ello, para propósitos de ingeniería

es más conveniente calcular en términos de velocidades correspondientes, las cuales son las velocidades de las

partículas correspondientes en tiempos correspondientes.

En el caso de la semejanza geométrica distorsionada, las relaciones de las velocidades correspondientes serán diferentes en las diferentes direcciones.

La semejanza cinemática es un estado de particular interés para los ingenieros químicos, porque si dos sistemas de fluidos son geométricamente semejantes, entonces los patrones de flujo también lo serán y las variaciones con respecto al tiempo de las transferencia de calor y masa en los dos sistemas, conformarán una relación simple entre sí.

Figura 2.4 Semejanza cinemática (De Johnstone y Thring, 1957).

La semejanza cinemática en los fluidos lleva consigo a la vez la semejanza geométrica de los sistemas de torbellinos y de las películas límites laminares y por consiguiente, si L es la relación de escala lineal. los coeficientes de tranferencia de calor y masa en el prototipo serán 1/L veces los del modelo, lo que permite calcular fácilmente la cantidad total de calor o masa transferido.

En sistemas fluidos tales como chorros líquidos en gases u ondas superficiales en vórtices, se pueden observar y medir normalmente los patrones de flujo, lo que no ocurre en sistemas cerrados de una sola fase. Sin embargo, queda el recurso de medir la velocidad en cualquier punto mediante el empleo de un tubo de Pitot y la indicación de la relación de velocidades en diferentes puntos es una indicación del patrón de flujo.

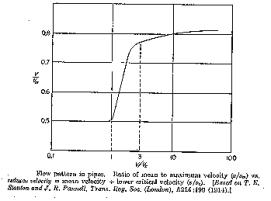

Para el flujo de fluidos en un tubo lleno o en un recipiente cilíndrico, la relación de la velocidad media a la velocidad máxima v/vm, resulta un parámetro conveniente. La velocidad media (v), se obtiene dividiendo el área de la sección transversal de la trayectoria del fluido entre la descarga volumétrica por segundo y la velocidad máxima vm, se mide con un tubo Pitot en el eje del tubo o cilindro. Para que haya semejanza cinemática, la relación v/vm debe ser constante.

La figura 2.5 muestra como varía la relación v/vm para flujo continuo en tuberías rectas, graficada contra la relación v/vc, conocida como velocidad reducida. En la región laminar (v/vc < 1 ) y de nuevo a altas velocidades, v/vm es constante o casi constante, pero inmediatamenmte por encima de la región de la velocidad crítica, varía marcadamente con la velocidad.

Esta figura resulta válida también para tuberías en forma de serpentín y recipientes cilíndricos, siempre y cuando se emplee la velocidad reducida en lugar de la velocidad real, a pesar de que los valores de la velocidad crítica serán diferentes.

Figura 2.5 Variación de la relación V/Vm en una tubería recta (De

Johnstone y Thring, 1957).

Esta figura ilustra la importante conclusión de que a velocidades de flujo muy altas o muy bajas los sistemas de flujo de fluidos monofásicos que son geométricamente semejantes, pueden ser tratados como semejantes cinemáticamente, con independencia de la variación de la velocidad del flujo.

Semejanza dinámica.

La semejanza dinámica se relaciona con las fuerzas que aceleran o retardan masas en movimientos en sistemas dinámicos. Las fuerzas de una misma clase (gravitacional, centrífuga, etc.) que actúan sobre partículas correspondientes en tiempos correspondientes, se denominan fuerzas correspondientes.

Los sistemas en

movimiento geométricamen-te semejantes son dinámicamente semejantes cuando las relaciones

entre todas las fuerzas correspondientes son iguales.

En los sistemas fluidos o en los sistemas compuestos por partículas sólidas discretas, la semejanza cinemática necesariamente conlleva la semejanza dinámica, puesto que el movimiento del sistema es función de las fuerzas aplicadas al mismo. Sin embargo en máquinas o mecanismos en movimiento cuyas partes están obligadas a seguir trayectorias fijas, es posible tener semejanza cinemática sin ninguna relación fijada de fuerzas aplicadas. En una máquina, sólo algunas de las fuerzas sirven para acelerar las masas en movimiento, mientras que otras producen tensiones estáticas en los miembros restringidos, provocando resistencia friccional que se disipa como calor.

Por ende los paralelogramos o polígonos de fuerzas para partículas correspondientes serán geométricamente semejantes y, como una consecuencia adicional, las relaciones de diferentes fuerzas en el mismo sistema, serán también constantes.

Estas relaciones son las proporciones o relaciones intrínsecas que determinan la "forma" dinámica de un sistema de la misma manera que las relaciones entre las dimensiones lineales determinan la forma geométrica. En los sistemas fluidos las fuerzas principales que actúan son las de presión, inerciales, gravitacionales, viscosas e interfaciales y por consiguiente, las relaciones entre las magnitudes de esas fuerzas en puntos correspondientes, expresadas como grupos adimensionales, constituyen los criterios de semejanza dinámica.

Para los llamados sistemas homólogos, o sea los sistemas dinámicos semejantes geométricamente en los cuales las propiedades físicas y químicas de los componentes materiales son iguales, generalmente no es posible establecer más de dos relaciones entre tres tipos de fuerzas, iguales en ambos sistemas. Cuando los sistemas no son homólogos, o sea cuando los materiales empleados en los dos sistemas son de diferentes propiedades físicas, llega a ser posible mantener tres relaciones constantes, involucrando cuatro tipos diferentes de fuerzas.

Cuando el comportamiento de un sistema es influído significativamente por fuerzas de más de cuatro tipos, la semejanza dinámica sólo puede establecerse en unos pocos casos especiales, posiblemente con la ayuda de la distorsión geométrica.

En los sistemas de flujo de fluidos, la semejanza dinámica es de importancia directa cuando se desean predecir caídas de presión o consumos de potencia. En el caso de la transferencia de calor y masa o en las reacciones químicas, su importancia es principalmente indirecta, como una vía para establecer la semejanza cinemática.

Semejanza térmica.

La semejanza térmica tiene que ver con los sistemas en los cuales hay un flujo de calor, por lo que introduce la dimensión de temperatura, además de las dimensiones de longitud, masa y tiempo.

El calor puede fluir de un punto a otro por radiación, convección, conducción y movimiento global de materia mediante la acción de un gradiente de presión. Para los primeros tres procesos se requiere un gradiente de diferencias de temperatura y por ello, si se mantienen las otras condiciones iguales, la variación con respecto al tiempo del flujo de calor entre dos puntos varía con la diferencia de temperatura entre ellos.

El cuarto proceso de transferencia de calor, el movimiento global de la materia, depende a su vez de la forma de movimiento o del patrón de flujo del sistema y por consiguiente en sistemas térmicos en movimiento, la semejanza térmica requiere de la semejanza cinemática.

Antes de definir la semejanza térmica, se necesita definir la diferencia de temperatura correspondiente, la cual es aquella diferencia de temperatura en tiempos correspondientes entre un par de puntos dados en un sistema y el par de puntos correspondientes del otro sistema.

La semejanza térmica se define entonces planteando que:

Dos sistemas geométricamente semejantes son térmicamente semejantes cuando la relación

entre las diferencias de temperatura correspondientes es constante y cuando los

sistemas, si están en movimiento, son cinemáticamente

semejantes.

En los sistemas semejantes térmicamente, los patrones de las distribuciones de temperaturas formados por las superficies isotérmicas en tiempos correspondientes, son geométricamente semejantes. La relación de las diferencias correspondientes de temperaturas puede ser llamada la "relación de escala de temperatura" y cuando esta relación es igual a la unidad, las temperaturas en puntos correspondientes son iguales o difieren una de otra en un número fijo de grados.

La semejanza térmica requiere que las razones de cambio correspondientes de los flujos de calor mantengan una relación constante entre sí.

Semejanza química.

La semejanza química se relaciona con sistemas en los que se desarrollan reacciones químicas y en los cuales la composición varía de un punto a otro y, en los procesos discontinuos o cíclicos de un instante a otro. Para esta semejanza no se requiere introducir nuevas dimensiones, pero hay uno o más parámetros de concentración, en dependencia del número de compuestos químicos variables independientes, con respecto a los cuales se establece la semajanza. No es necesario tampoco que la composición química en los dos sistemas sea la misma, aunque debe existir una relación fija entre las concentraciones puntuales de los compuestos que son comparados.

Cuando un sistema contiene un componente variable B y se desea establecer semejanza con respecto a un componente A, ambas sustancias se denominarán componentes correspondientes. La concentración de un componente químico dado en un elemento de volumen en un tiempo dado, depende de la concentración inicial,

la razón mediante la cual el componente es generado o destruído por la acción química, la razón por la que se difunde hacia adentro o hacia afuera del elemento de volumen y la razón por la cual es transportado por movimiento global del material.

A su vez, la variación con respecto al tiempo de la acción química depende de la temperatura, la razón de cambio de la difusión depende del gradiente de concentración y la razón de cambio del transporte global depende de la trayectoria del flujo.

Por consiguiente la semejanza química necesita tanto de la semejanza térmica como de la cinemática y depende de las diferencias de concentración más que de las concentraciones absolutas.

Se definen las diferencias de concentración correpondientes, como la diferencia de concentración en tiempos correspondientes, entre un par de puntos dados de un sistema y el par de puntos correspondientes del otro sistema. Con esa base se define la semejanza química:

Sistemas semejantes

geométrica y térmicamente son semejantes

químicamente cuando las

diferencias de concentraciones correspondientes

mantienen una razón constante entre

ellas y cuando dichos

sistemas, si están

en movimiento, son cinemáticamente semejantes.

En los sistemas semejantes químicamente se puede considerar que los patrones formados por las superficies de composición constante en tiempos correspondientes, son geométricamente semejantes. La relación de las diferencias de concentraciones corrrespondientes se pueden llamar la "relación de escala de concentraciones" y cuando ese valor es igual a la unidad, las concentraciones en puntos correspondientes o son iguales o difieren en una cantidad constante.

En la práctica los reactores químicos de escala piloto son casi siempre operados en iguales condiciones de temperatura y concentración que el prototipo y la relación de semejanza reclamada es la de iguales temperaturas y concentraciones de productos en puntos y tiempos correspondientes, lo cual es un caso especial de la definición general dada más arriba.

Además, la variación con respecto al tiempo de una reacción química puede en teoría ser variada independientemente, cambiando la temperatura. En la práctica, sin embargo, tanto el equilibrio químico como las razones de cambio relativas de las reacciones colaterales indeseadas varían con la temperatura y hay normalmente un rango estrecho de temperaturas dentro del cual la reacción puede proceder par asegurar el máximo rendimiento, tanto en la pequeña como en la gran escala.

Tanto en el modelo como en el prototipo, el tiempo de reacción será del mismo orden y este requerimiento fija las velocidades relativas en sistemas de flujo continuo. Esas velocidades son incompatibles con las velocidades necesarias para semejanza cinemática, exepto a velocidades mmuy altas o muy bajas, como se pudo apreciar en la figura 2.4.

Por consiguiente, escalando ascedentemente una reacción química continua, y especialmente cuando hay un tiempo óptimo de reacción, después del cual el rendimiento o la calidad se reduce, es ventajoso operar tanto el prototipo como el modelo en la región laminar o con un alto grado de turbulencia. Si ninguna de esas condiciones es posible, habrá un efecto de escala impredecible y sería prudente en ese caso,o hacer el escalado ascendente en varias etapas o emplear amplios factores de seguridad en el diseño.

2.1.3 Criterios de semejanza.

Introducción.

El análisis hecho sobsre la definición de semejanza en los distintos sistemas de interés para la Ingeniería Química y Bioquímica conduce, en todos los casos, al planteamiento de las condiciones necesarias para la existencia de semejanza entre prototipo y modelo. Esas condiciones son expresads como igualdades entre razones de magnitudes correspondientes dentro del mismo sistema, que toman la forma de grupos adimensionales.

Al analizar cualquier

sistema, la semejanza se determina

por la igualdad del valor de dichos

grupos en el prototipo y en el modelo.

Estos grupos constituyen los criterios

de semejanza entre los sistemas comparados. Así, por ejemplo, el número de

Raynolds es el criterio de semejanza dinámico para sistemas de flujo

geometricamente semejantes.

Obtención de los criterios de Semejanza.

Se ha mencionado anteriormente que la semejanza química, térmica o mecánica entre sistemas geométricamente semejantes pueden ser especificadas en términos de criterios que son relaciones intrínsecas de mediciones, fuerzas o razones de cambio dentro de cada sistema. Puesto que esos criterios son relaciones de cantidades de igual magnitud, resultan ser adimensionales y existen dos métodos generales de obtenerlos.

Cuando son desconocidas las ecuaciones diferenciales que gobiernan el comportamiento de un sistema, pero se conocen todas las variables que deben entrar en dichas ecuaciones diferenciales, es posible obtener los criterios de semejanza por medio del análisis dimensional. Cuando las ecuaciones diferenciales del sistema se conocen pero no pueden ser integradas, los criterios de semejanza se pueden derivar de la forma de las ecuaciones diferenciales.

En los casos en que se conozcan las ecuaciones diferenciales y además éstas se pueden integrar y resolver, no hay en general necesidad de los criterios de semejanza ni de los experimentos con modelos, puesto que el comportamiento del sistema a gran escala puede ser directamente calculable.

Análisis Dimensional.

El análisis dimensional es una técnica para expresar el comportamiento de un sistema físico en términos de un número mínimo de variables independientes y en una forma tal que no resulten afectadas por los cambios de las magnitudes de las unidades de medidas. Las cantidades físicas se agrupan en grupos adimensionales consistentes en relaciones de magnitudes iguales (longitudes, velocidades, fuerzas, etc.) que caracterizan el sistema, los que constituyen las variables en la ecuación adimensional de estado (o de movimiento) del sistema.

El análisis dimensional puede brindar resultados incorrectos a menos que se hayan tenido en cuenta cada una de las variables que influyen significativamente en el sistema que se está analizando, por lo cual es necesario conocer bastante sobre los mecanismos de un proceso antes de poder aplicar con confianza este método. La clave del éxito está en la selección inicial de las variables.

Si la lista de variables es muy larga y se incluyen por lo tanto variables cuyo efecto no es apreciable, los factores superfluos se pueden eliminar a veces durante el análisis, pero en la mayoría de los casos esto no es posible y el número de criterios de semejanza obtenidos resulta innecesariamente grande y el problema de alcanzar la semejanza aparece más difícil de lo que realmente es. Si por el contrario, se omite alguna de las variables realmente relevantes en el sistema, el análisis dimensional llevará a una falsa conclusión.

De lo antes expuesto se deriva el hecho de que la aplicación del análisis dimensional aisladamente es muy difícil que nos conduzca a obtener un conocimiento completamente nuevo. Muchas de las aplicaciones clásicas de este método lo que han hecho realmente es confirmar las relaciones que ya se conocían o al menos se sospechaban, lo que de hecho elimina la dificultad principal de la selección inicial de las variables.

Para obtener los criterios de semejanza a partir del Análisis Dimensional se utiliza el Teorema de Buckingham y el Método de Railegh y se parte de conocer todas las variables que intervienen en un proceso dado, como se ha dicho anteriormente. La aplicación de estos métodos se pueden estudiar en diferentes textos como los de Jonhstone y Thring (1957), Perry y Green (1986) y Rosabal (1988).

Ecuaciones Diferenciales.